Googleの検索エンジン

Google の検索エンジンが日本語に対応したのは2000年で、 シンプルなデザインと検索結果の正確さで他の検索エンジンを凌駕し、2000年代中盤から後半にかけて Gmail や Google Maps などのサービス展開もあり、急速に普及していった。

2009年には日本国内でも Google のシェアは 70%を超え、2010年には Yahoo が検索エンジンのプログラムに Google を採用したため、国内の検索エンジンは実質的に Google が 9割を占め、Google の SERP ( 検索した際に表示される検索結果ページ ) での上位表示は、トラフィック増加に欠かせない課題になり、Google の検索アルゴリズムを攻略してウェブサイトを最適化する SEO(Search Engine Optimization)が重視されるようになる。

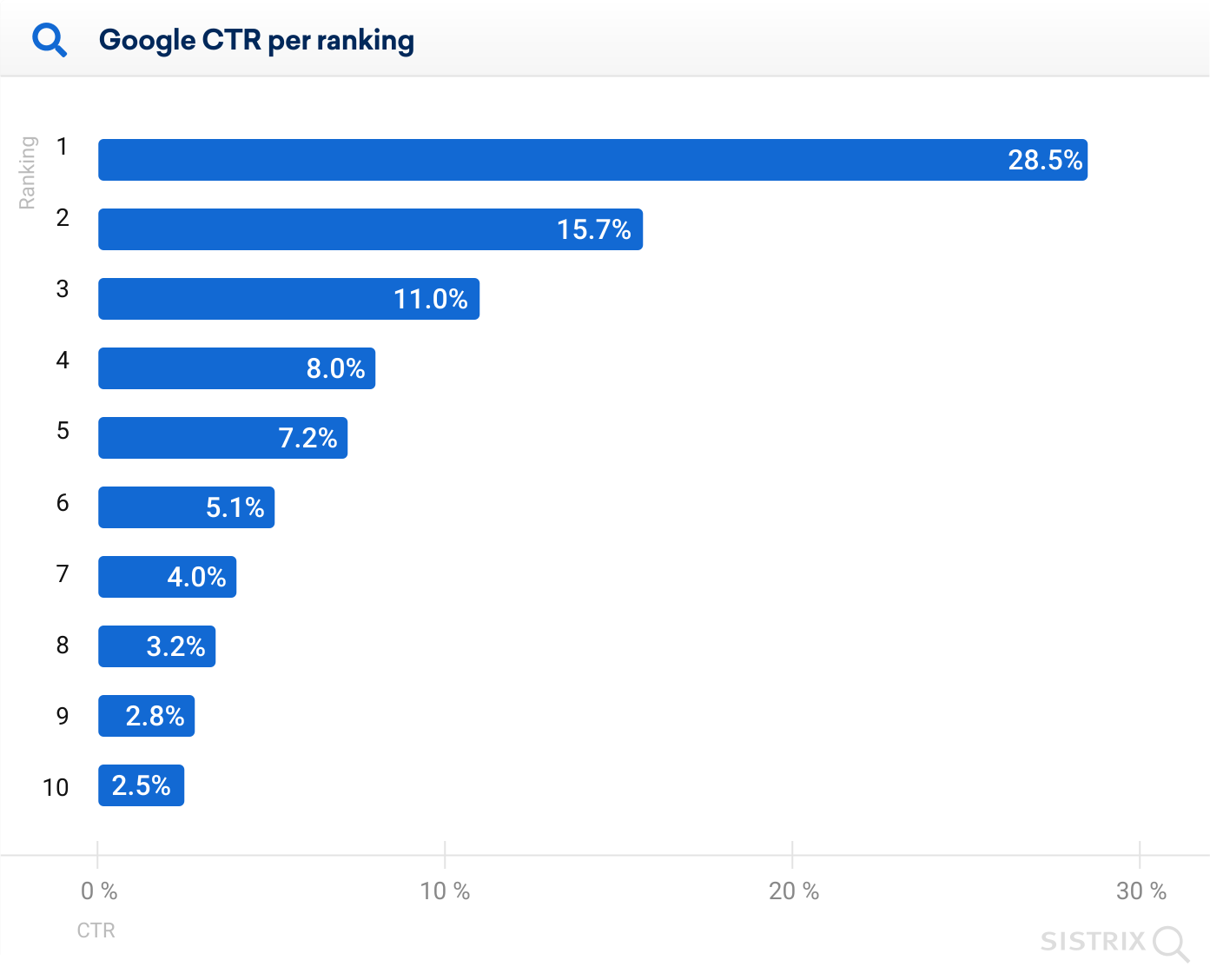

2020年に発表された SISTRIX の調査結果 では SERP のランキング1位の平均クリック率は28.5% と約3割ほどあり、2位 15.7%、3位 11.0% と 3位までで 55%を占め、1ページ目で 88% がクリックしている。

この結果は 2017年に発表された Internet Marketing Ninjas の数値よりも上位のウェイトが向上しているが、SERP のランキング1位の重要性は揺るぎない。

検索アルゴリズム

Google 初期の検索アルゴリズムは、他のウェブページからのリンクの数や質に基づいてウェブページの信頼性と権威性を評価した ページランク を重視し、Googleツールバー などでページランクを確認することもできたが、2016年4月にページランクの公開を停止。

現在 Google の検索アルゴリズムは不透明で、 ガイドライン には 情報価値の高い、信頼性のある、ユーザーフレンドリーなコンテンツ を評価すると、抽象的な表現の記載があるだけで、具体的な指針が欠如しており、ページランクのような評価も得られず、問題点も指摘されないままランキングが変動する。

パンダアップデート と呼ばれる 2011年の検索アルゴリズム更新では、低品質なコンテンツや重複コンテンツ、スクレイピング(他のサイトからのコンテンツの複製)などの問題を抱えるウェブサイトが特定されてランキングが一挙に下がり、翌 2012年には ペンギンアップデート と呼ばれる検索アルゴリズム大規模更新が実施され、リンクスキーム(不自然なリンクの構築)、キーワードスタッフィング(過剰なキーワードの使用)などの不正なSEO手法に対してペナルティを科し、ウェブスパムのテクニックに対処するなど、2010年代のアルゴリズムの大型アップデートは明確で、ランキングを大きく落としても問題点を改善すれば半年ほどで回復していた。

一般的に Google の検索アルゴリズムは、高品質なコンテンツ・モバイルユーザビリティ・ユーザーエクスペリエンス が重視されている要素だと言われているが、検索アルゴリズムは年々 複雑化しており、2023年4月には ページエクスペリエンス・モバイルフレンドリー・ページ速度・安全なサイト(https/SSL)が「概念」だとして、ランキングシステムのリスト から削除された。

ページエクスペリエンス や ページ速度 は SERP に大きな影響がないという噂は2020年頃からあり、リストからの削除はそれを裏付けるような形になったが、近年の Googleの検索アルゴリズムは迷走しているかのように SERP に大きく影響を及ぼすようなアルゴリズムの変更やアップデートが頻繁に実施され、それまで上位表示されていた質の高いサイトがランクを落とすようになった。

Google のジョン・ミューラー氏がサイト運営者からの問いに対し、Twitter上で「サイトに問題がなくてもアルゴリズムの更新でランキングは下がることがある」と回答しているように、Google のガイドラインを遵守してもランキングは下がることがあり、被リンクの数はランキングに関係ないとしながら、大量のバックリンクを持つスパムサイトが上位表示される矛盾があり、多くの SEO 関係者が嘆いているように「 もはや Google が何を望んでいるのか分からい。」状況に陥っている。

検索上位を占めるスポンサーサイト

Google が上陸するまで国内の検索エンジンは ディレクトリ型 の Yahoo!JAPAN が最大シェアだったが、Yahoo!はポータルサイトのサービスとして検索エンジンを提供していたのに対し、Google は検索と広告を結びつけた新たなビジネスモデルを確立し、後にプライバシー侵害や反トラスト法違反にまで発展するほどの成功を収める。

Googleは独占禁止法違反(反トラスト法違反)で2017年6月に欧州で「自社のショッピング検索サービスを優先的に表示」したとして24億2000万ユーロ(約3,000億円)の制裁金が科されたほか、2018年7月に欧州で「自社の比較サイトを優先的に表示」したとして43億4286万500ユーロ(約5700億円)、2019年3月には「オンライン広告市場で独占的な地位を悪用」したとしてEU競争法違反で14億9446万ユーロ(約1900億円)など、いずれも係争中だが、欧州だけでも約1兆円の罰金を巡って裁判が行われているほか、Android関連も合わせると米国・オーストラリア・韓国・インドなど世界中で提訴されている。

以前の SERP でのスポンサーサイトは検索結果の上に白抜きのボックスで表示されていたが、現在は検索結果の上位に表示されるほか、Amazon・楽天が常に上位にあり、検索ワードによっては GoogleマップやYouTubeのカルーセルなど SERP機能が表示され、1ページ目が広告と SERP機能で埋まっていることもあり、オーガニック検索でランキング1位を獲得しても以前のようなトラフィックを獲得できないようになった。

トラフィックの多いサイトでは Googleがトラフィックの上限を設定して調整しているとの噂もある。

AI検索

2016年に発生した WELQ問題 は、DeNAが運営していた医療系のキュレーションサイト WELQで、外部委託のライターが他のサイトからの寄せ集めで作り上げた不確かな記事を、監修もせずに掲載していたもので、この問題を機に Googleは E-A-T と呼ばれる、記事の 専門性(Expertise)・権威性(Authoritativeness)・信頼性(Trustworthiness)を重視するようになった。

WELQ を始め DeNA が運営していたキュレーションサイトは閉鎖に追い込まれ、Google は信頼できる質の高い記事を作成するよう繰り返し発信しているが、AI検索も一種のキュレーションで、WELQ と同じようにインターネットで公開されている情報を寄せ集めて情報の真偽を検証することもない。

さすがに YMYL(Your Money or Your Life)と称される金融や健康などの情報は制限されると思われるが、現状の ChatGPT や Bing AI なども日時や数値の誤りが多い。

Googleが推進していた「質の高い記事」を作成しても、検索AI によって内容がスクレイピング(Webサイトから大量の情報を自動的に抽出する技術)されてユーザーに示めされ、情報を提供しているサイトはトラフィックを失う結果になる。

これから個人や中小の弱小サイトが生き残るには、SERPの上位表示に依存しないトラフィックの獲得しかない。